'AI'가 생산한 콘텐츠 중 부적절한 것들을 걸러내는 업무를 맡은 '사람'이 큰 스트레스를 받고 있는 것인데요. 이는 미국 월스트리트저널(WSJ)의 7월 24일(현지시간) 보도로 드러났습니다.

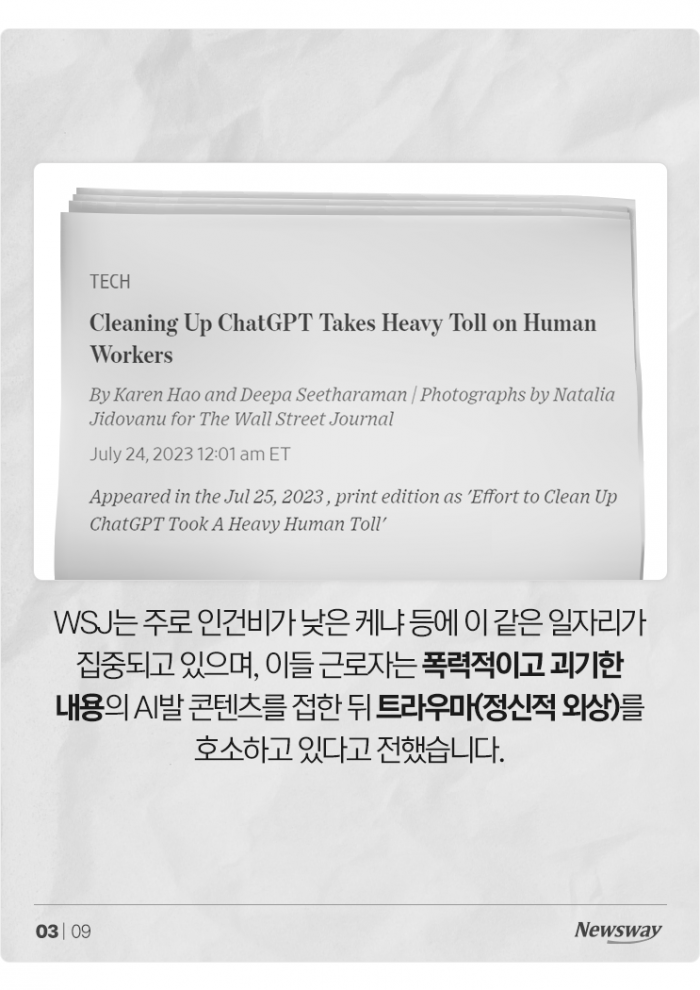

WSJ는 주로 인건비가 낮은 케냐 등에 이 같은 일자리가 집중되고 있으며, 이들 근로자는 폭력적이고 괴기한 내용의 AI발 콘텐츠를 접한 뒤 트라우마(정신적 외상)를 호소하고 있다고 전했습니다.

기업들은 '값싼' 근로자에게 AI가 만든 수천 개의 콘텐츠를 보고 분류하는 업무를 떠맡겼는데, 여기에 폭력·괴롭힘·자해·성폭력에 심지어 아동 성폭력에 대한 상세한 묘사까지 포함된 것이지요.

참혹하기 이를 데 없는 내용을 일일이 들여다봐야 하는 근로자들은 정신적 고통을 토로하기에 이르렀습니다. 케냐 노동자인 알렉스 카이루는 WSJ에 "그 일을 한 4개월은 최악의 경험"이라고 전하기도 했습니다.

AI가 이렇듯 유해 콘텐츠도 서슴없이 내놓는 건 생성형 AI들이 인터넷 속 가공할 양의 디지털 문서를 학습하는 거대언어모델(LLM)을 기반으로 구동되기 때문. 인터넷 속 나쁜 콘텐츠 역시 배움의 대상으로 삼는 것이지요.

못된 것도 잘 배운다는 점에서 사람과 똑 닮은 AI인데요. 근로자들은 케냐 의회에 AI 유해 콘텐츠에 노출되는 일의 위험성을 인식하고 관련 노동자 보호를 위한 법안 마련을 요구했습니다.

본격적으로 드러나기 시작한 AI의 유해성 문제. 우리나라에서도 챗GPT를 이용한 자기소개서 작성이나 소설·시나리오·그림 등 공모전 출품에 AI 힘을 빌리는 것 등이 점차 이슈화되고 있는데요.

공정한 경쟁이 요구되는 부문에서 AI를 어떻게 걸러낼지, 또 AI 생산 콘텐츠의 검열, 활용 범위, 저작권 문제까지, 앞으로 풀어야 할 숙제가 많습니다.

AI와 함께 살기, 쉽지만은 않네요.

뉴스웨이 이성인 기자

silee@newsway.co.kr

저작권자 © 온라인 경제미디어 뉴스웨이 · 무단 전재 및 재배포 금지

댓글